Még az előző év novemberében írtunk arról, hogy házon belül fejlesztett hardvereket kap a Microsoft Azure. Ekkor derült ki, hogy készül egy Maia 100 nevű AI gyorsító, de a specifikációi ismeretlenek voltak. Egészen mostanáig, ugyanis az idei Hot Chips alkalmával a redmondi óriáscég bővebben is részletezte, hogy mit is készítenek.

Hirdetés

A Maia 100 egy 820 mm²-es lapka, ami a TSMC 5 nm-es node-ján készül, a tokozásra pedig CoWoS-S interposer technológián keresztül 64 GB-nyi HBM2E memória kerül, amely 1,8 TB/s-os memória-sávszélességet tesz lehetővé. A teljes dizájn 700 wattos TDP keretre van tervezve, de a gépi tanulás következtetésre vonatkozó szakaszában tipikusan 500 watt körül fog működni.

Az összesen nagyjából 500 MB-os L1 és L2 gyorsítótárakkal rendelkező rendszer x8-os PCI Express 5.0-s interfészen köthető be az adott konfigurációba, továbbá 12 darab 400 GbE interfészt biztosít, összesen 600 GB/s-os sávszélességgel.

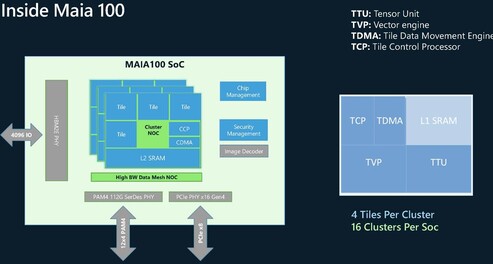

A belső felépítést tekintve a Maia 100 fő feldolgozóblokkja egy tensor egységből, egy vektormotorból, egy vezérlőprocesszorból, illetve egy adatmozgatásért felelős részegységből áll. Ezt hívja a Microsoft Tile-nak, és négy ilyen Tile van egy klaszterben, miközben 16 darab klaszter van egy lapkán belül. A tensor egység 9 és 6 bites formátumot dolgozhat fel, míg a vektormotor FP32 és bfloat16 operációkat támogat.

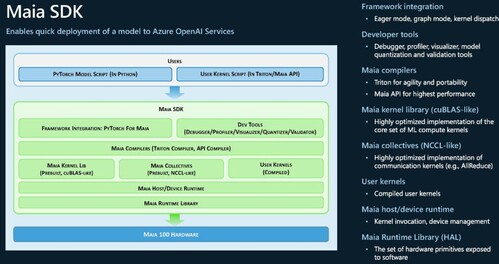

A Maia 100-hoz a Microsoft kínál magas és alacsony szintű hozzáférést, előbbi nyilván hardveragnosztikus, míg utóbbi ténylegesen a célzott hardverre szabott kódot eredményez. Persze a rendszeren futtatható a PyTorch is.